MacMini M4 本地部署运行 DeepSeek R1 大模型

MacMini M4 本地部署运行 DeepSeek R1 大模型

一、模型介绍

DeepSeek R1 是由 DeepSeek 公司开发的一款基于 LLaMA 模型的开源大模型,它在多个基准测试中表现出色,包括 GSM8K、MATH、ARC、BBH 等。

下面介绍我们在自己的机器上部署该大模型。

二、部署工具

推荐使用 Ollama 框架,它支持 macOS 的本地模型管理,并简化了依赖安装流程:

安装 Ollama

- 官网下载安装

![官网下载安装]()

- 在终端执行命令一键安装:

1

curl -fsSL https://ollama.com/install.sh | sh

验证安装:

ollama -v。- 官网下载安装

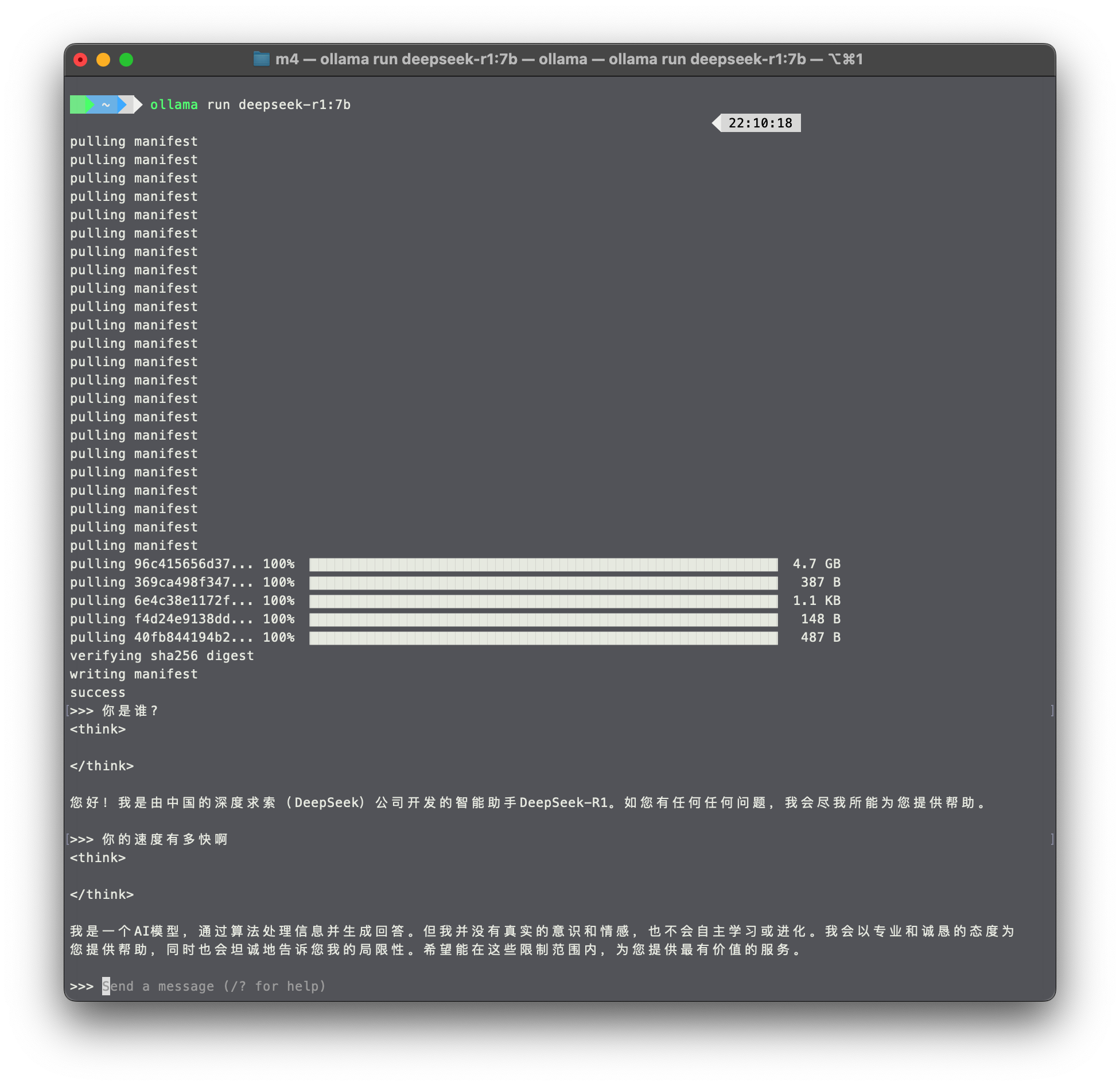

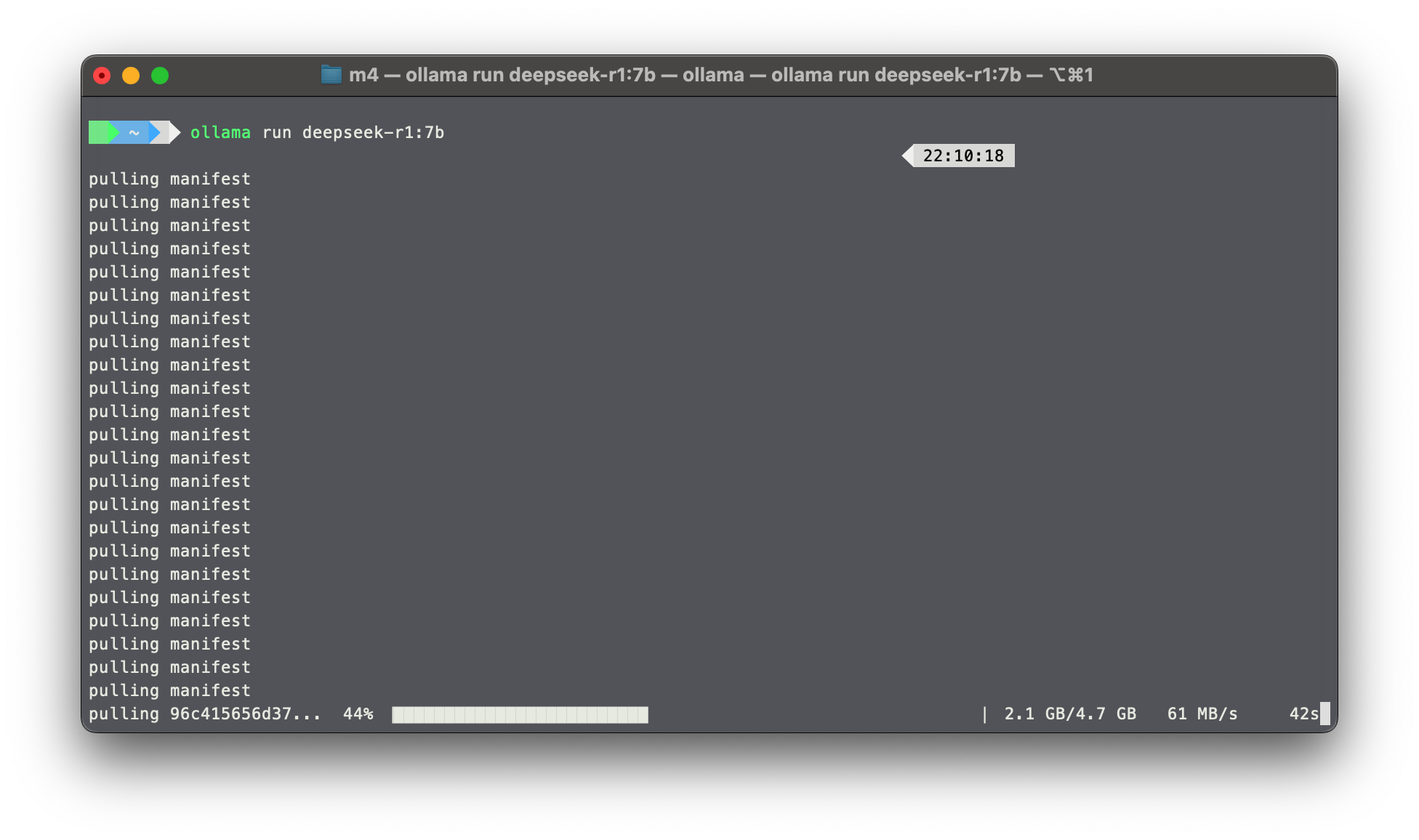

下载模型

运行命令下载 7B 模型:1

ollama run deepseek-r1:7b

模型将自动下载至本地(约 4.7GB)。

三、交互方式

终端直接对话

运行ollama run deepseek-r1:7b后输入问题即可,退出输入/bye。![23-03-12-命令行运行]()

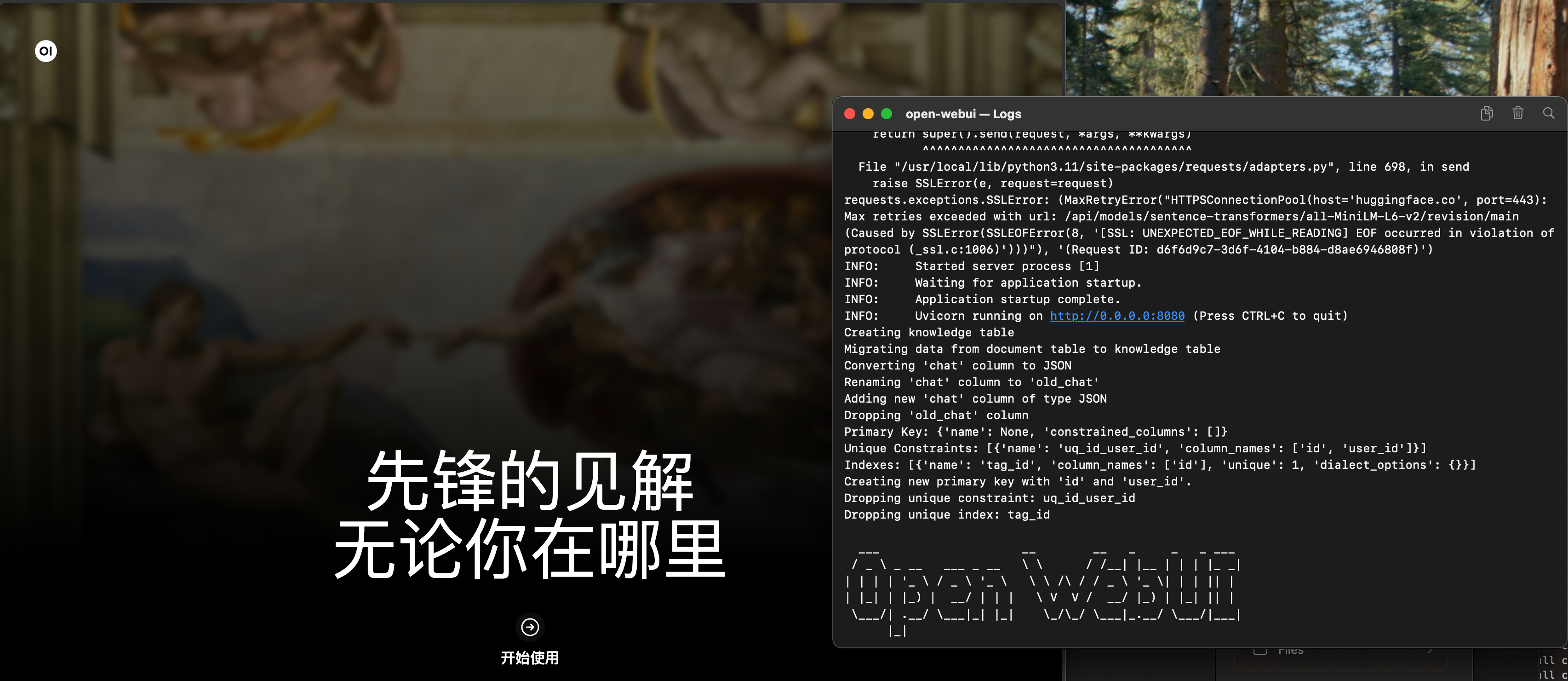

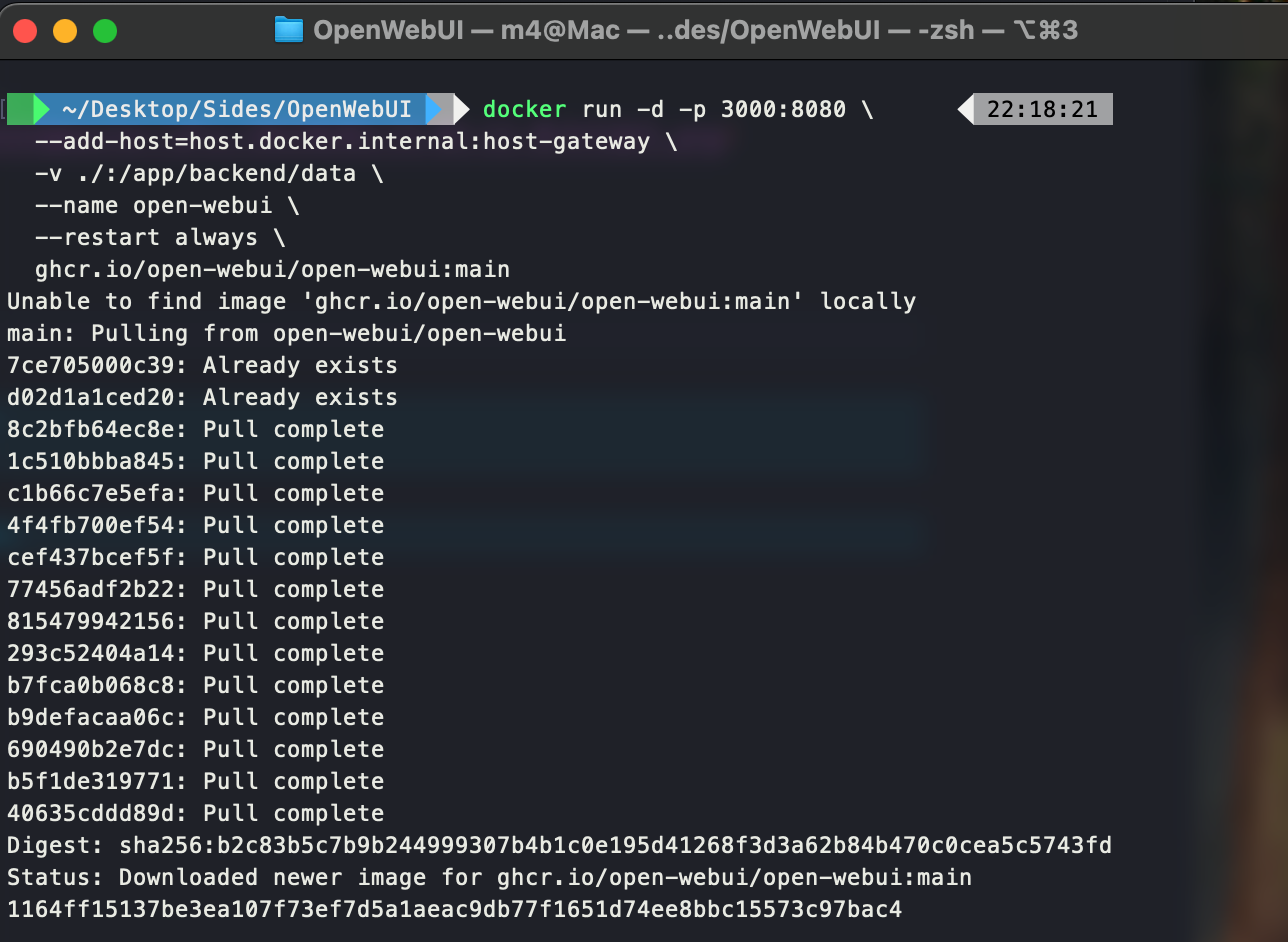

Web 界面(推荐)

使用 Open WebUI 提供类似 ChatGPT 的图形界面:1

2

3

4

5

6docker run -d -p 3000:8080 \

--add-host=host.docker.internal:host-gateway \

-v open-webui:/app/backend/data \

--name open-webui \

--restart unless-stopped \

ghcr.io/open-webui/open-webui:main

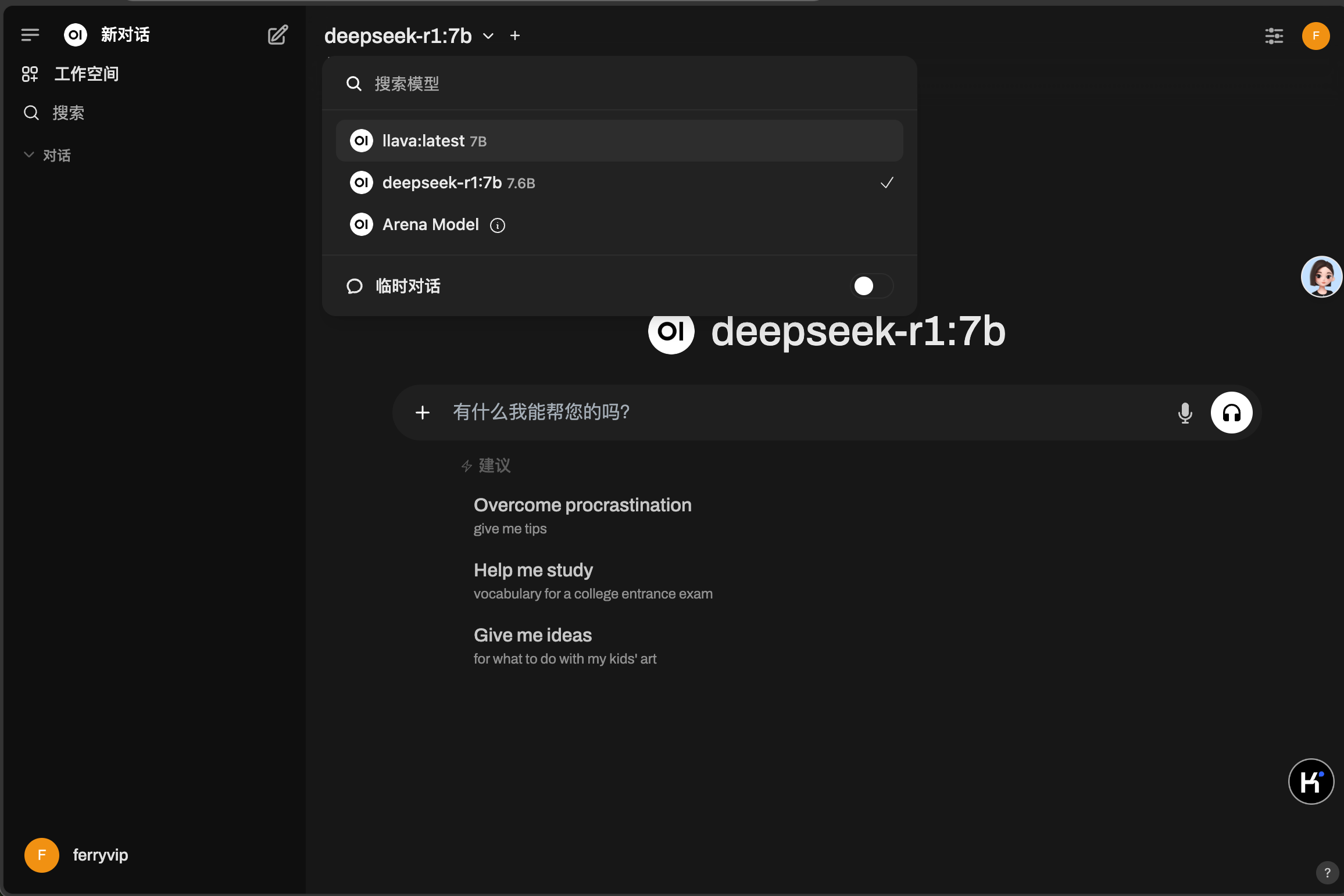

访问 http://localhost:3000,选择 deepseek-r1:7b 即可使用。

OpenWebUI初始化界面

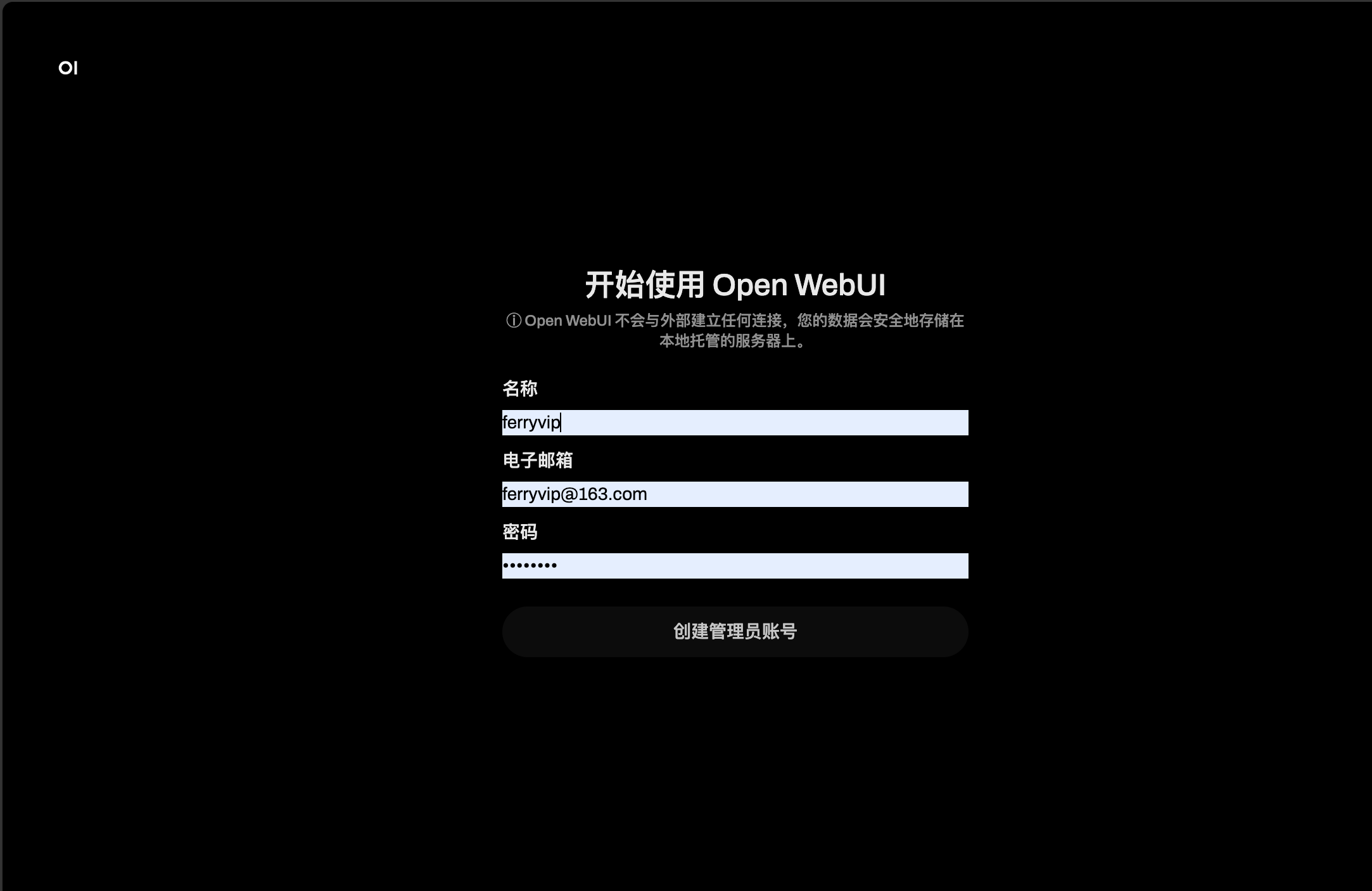

创建管理员账号

选择模型开始对话

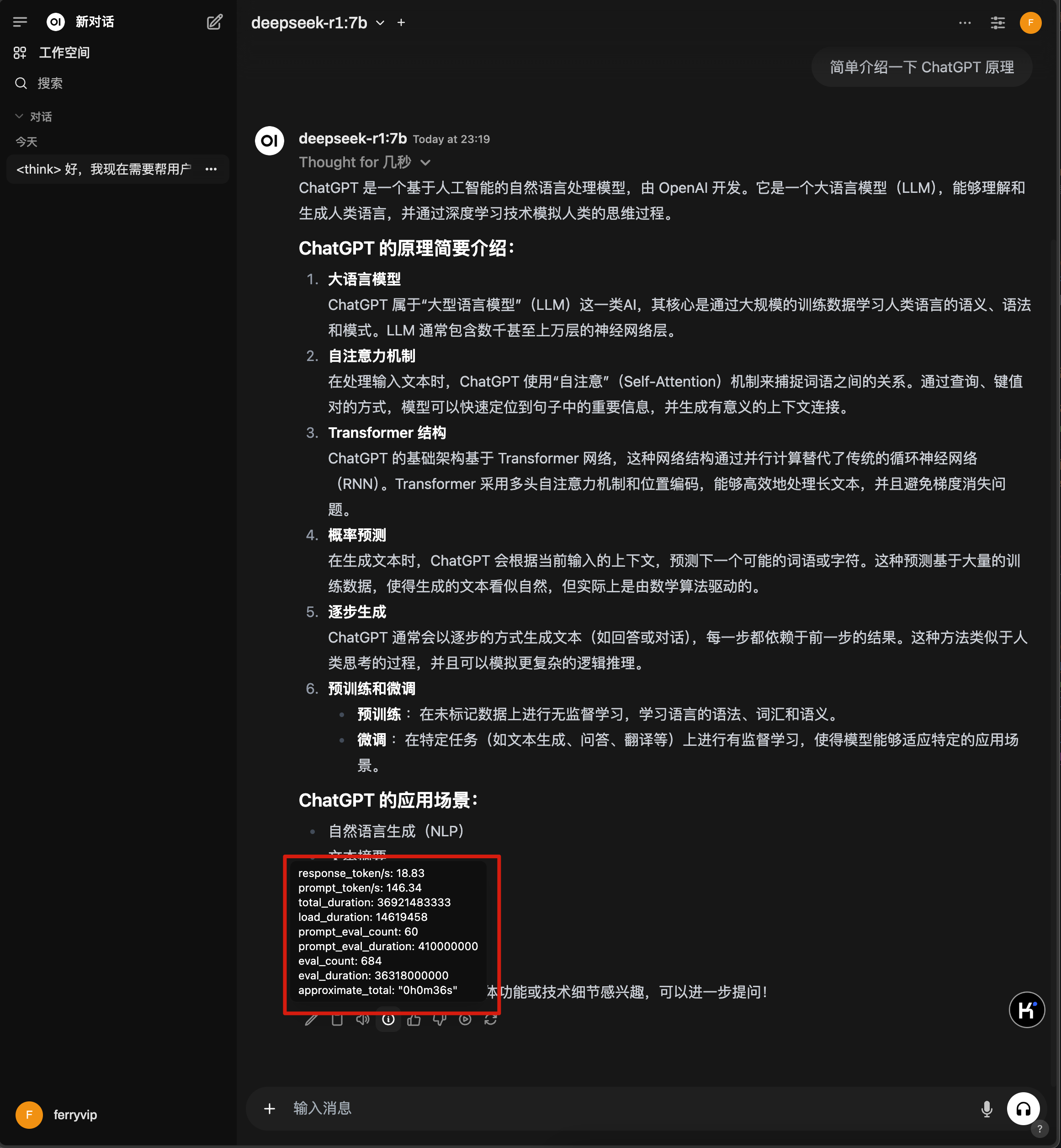

模型对话

本地模型速度

总结

通过 Ollama 框架,我们可以方便地在本地部署和运行 DeepSeek R1 大模型,实现高效的交互体验。在 MacMini M4 16GB 内存最低配的机器上,发现模型运行速度还是很不错的,基本可以满足日常使用。